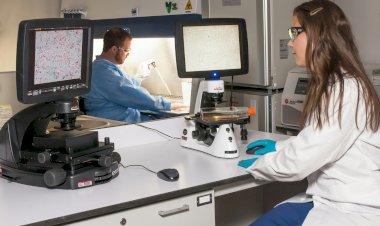

IA y privacidad; la sostenibilidad legal del machine learning

Ponencia de Sandra Ordoñez perteneciente al módulo Metaverso, IA y tecnologías inmersivas y transformación digital de C1b3rWall Academy 22/23

Tiempo de lectura estimado: 6 minutos

¿Qué es la inteligencia artificial (IA)? ¿Y el machine learning (ML)?

La IA hace referencia a un término general que engloba aquellas tecnologías que tienen como objetivo imitar las capacidades de razonamiento humano. Es una tecnología en continuo avance y desarrollo, tanto por parte de las empresas como de las entidades públicas. Por otro lado, el machine learning es una rama específica de la IA en la que se busca, a través de conjuntos de datos, utilizar algoritmos que permitan hacer clasificaciones o predicciones.

Es importante realizar una precisa depuración de los datos para utilizar solo aquellos que necesite nuestra herramienta.

Malentendidos sobre el machine learning

La Agencia Española de Protección de Datos (AEPD) ha elaborado una guía acerca de los principales malentendidos, de la que se pueden destacar tres:

- "Cuantos más datos y mayor sea la variedad, mejor". No es así, los datos deben seleccionarse para cumplir umbrales de precisión y representatividad.

- "La transparencia en ML viola la propiedad intelectual y no es entendida por el usuario". Se debe ofrecer no solo información técnica detallada, sino que los responsables deben informar de los posibles impactos en la vida diaria.

- "Los sistemas de ML están sujetos a diferentes tipos de sesgos, algunos humanos". Sí, se producen sesgos, pero se generan en función de sus características inherentes.

Propuesta de reglamento europeo por el que se establecen normas armonizadas en materia IA

El objetivo es crear una inteligencia artificial fiable para los ciudadanos. La propuesta tuvo lugar en abril de 2021 e inspiración en el libro blanco publicado por la Comisión Europea. Entrará en vigor en enero de 2024 y se enfoca en el concepto del riesgo, proporcionando soluciones y defensa de los derechos fundamentales de los ciudadanos frente a aquellos riesgos que puedan suponer los sistemas de IA. Se establece una clasificación de riesgos:

- Riesgo inadmisible: clara amenaza para la seguridad de los derechos de los ciudadanos, por lo que es un riesgo prohibido.

- Alto riesgo: se deben analizar los posibles riesgos que puedan impactar en la seguridad de los ciudadanos.

- Riesgo limitado: obligaciones de transparencia hacia los interesados.

- Riesgo mínimo o nulo: autorregulación.

Las obligaciones con el reglamento pasan por la gestión de riesgo, la gobernanza de datos, el registro de documentación (trazabilidad), la vigilancia humana, la precisión, la solidez y la ciberseguridad. Se establecen, así mismo, sanciones que van desde los 10 hasta los 30 millones de euros, en función del tamaño de la empresa y de las obligaciones.

Conclusiones

- Las nuevas tecnologías avanzan muy rápido en comparación con el ámbito jurídico, que se queda atrás en estos ámbitos, lo que supone nuevos riesgos.

- Hay dificultad para encontrar expertos en la materia.

- Existe necesidad de concienciar en el ámbito tecnológico.

- Se debe garantizar, desde una perspectiva ética y jurídica, la protección de los derechos fundamentales del ciudadano.

¿Todavía no formas parte de C1b3rWall Academy? El contenido es gratuito, únete a otras miles de personas desde este enlace.

Si te interesa este tema, puedes consultar la información y cursar el Máster en Blockchain y Smart Contracts o ver la oferta de másteres desde aquí.

Ponente: Sandra Ordoñez

Sandra es consultora en Secure & IT y experta en derecho de las nuevas tecnologías. Es graduada en derecho y especializada en el Derecho de las Nuevas Tecnologías y Propiedad Intelectual. Contacto: Sandra Ordoñez (LinkedIn).

¿Cuál es tu reacción?